Aunque con el cambio de modelo de negocio, de uno basado en audiencias masivas a otro en el que se concede más peso a la calidad y a la relación con el suscriptor, el volumen de comentarios ha descendido mucho, dado que no pocos periódicos ya sólo permiten comentar a los suscriptores de pago, o a los que al menos se registran, la tarea de moderación aún sigue necesitando de recursos humanos importantes, en caso de que la moderación sea interna, o de dinero para subcontratarlo a empresas especializadas.

Pero la tecnología podría ayudar a los periódicos a hacer más eficiente esa labor y destinar esos recursos a periodismo de calidad. Es, al menos, lo que puede suceder si las pruebas que está realizando Facebook en la red social tienen éxito y se acaba generalizando en los medios de comunicación también la automatización de esta tarea, si no toda, gran parte, merced a la inteligencia artificial.

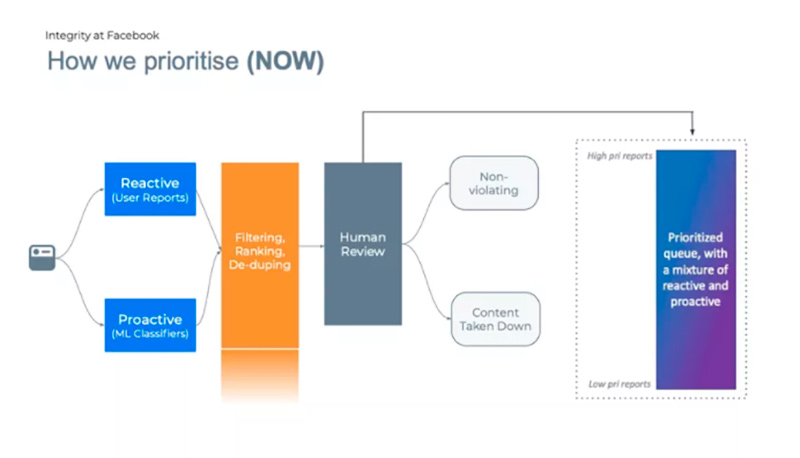

Según publicaba The Verge, ahora, las publicaciones en Facebook que se cree que violan las reglas de la empresa (que incluyen todo, desde spam hasta discursos de incitación al odio y contenido que “glorifica la violencia”) son marcadas, ya sea por los usuarios o por los filtros de aprendizaje automático. Algunos casos muy claros se resuelven automáticamente (las respuestas podrían implicar la eliminación de una publicación o el bloqueo de una cuenta, por ejemplo), mientras que el resto entra en una cola para que los moderadores humanos los revisen.

Tres criterios para priorizar: viralidad, gravedad y probabilidad de que no cumplan las normas

Hasta hace poco, los moderadores revisaban las publicaciones de forma más o menos cronológica. Ahora, Facebook dice que quiere asegurarse de que las publicaciones más importantes se vean primero y está utilizando el aprendizaje automático para facilitar la tarea. En el futuro, se utilizará una amalgama de varios algoritmos de aprendizaje automático para ordenar esta cola, priorizando las publicaciones en función de tres criterios: su viralidad, su gravedad y la probabilidad de que estén rompiendo las reglas.

Facebook emplea a unos 15.000 moderadores en todo el mundo y ha sido criticado en el pasado por no brindarles suficiente apoyo, empleándolos en condiciones que pueden conducir a un trauma. Su trabajo es clasificar las publicaciones marcadas y tomar decisiones sobre si violan o no las diversas políticas de la empresa.

No está claro exactamente cómo se ponderan estos criterios, apunta el reportaje, pero Facebook dice que el objetivo es lidiar primero con las publicaciones más dañinas. Cuanto más viral sea una publicación (cuanto más se comparta y se vea), más rápido se tratará. Lo mismo ocurre con la gravedad de una publicación. Facebook dice que clasifica las publicaciones que involucran daños en el mundo real como las más importantes. Eso podría significar contenido que tenga que ver con terrorismo, explotación infantil o autolesiones. Mientras tanto, las publicaciones como el spam, que son molestas pero no traumáticas, se clasifican como las menos importantes para su revisión.

“Todas las violaciones de contenido recibirán una revisión humana sustancial, pero usaremos este sistema para priorizar mejor [ese proceso]”, dijo Ryan Barnes, gerente de producto del equipo de integridad de la comunidad de Facebook, durante una conferencia de prensa.