“Si un sitio web ha publicado noticias falsas anteriormente, es muy probable que lo hagan de nuevo”, dijo en un comunicado el asociado postdoctoral MIT CSAIL Ramy Baly, autor principal de un artículo sobre la tecnología, recoge Fast Company

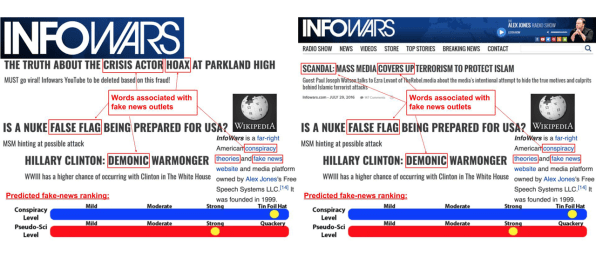

La herramienta utiliza una técnica de aprendizaje automático conocida como máquinas de vectores de soporte para aprender a predecir cómo se clasificarán los medios según Media Bias / Fact Check, una organización que rastrea el nivel de contenido objetivo y el sesgo político en miles de sitios de noticias. Toma en cuenta el contenido real de los artículos en los sitios, así como factores externos como la presencia en Twitter del sitio, la estructura de su nombre de dominio en línea y cómo se describe en Wikipedia.

“En una entrevista, la fuente de información más útil para juzgar tanto la realidad como el sesgo son los artículos reales”, dice Preslav Nakov, científico principal de QCRI.

Tal vez, como era de esperar, “los sitios menos factuales tenían más probabilidades de usar lenguaje hiperbólico y emocional que los que informaban más contenido fáctico”, según el artículo de Fast Company.

Además, dice Nakov, las fuentes de noticias con descripciones más extensas en Wikipedia tienden a ser más confiables. La enciclopedia en línea también puede proporcionar indicaciones verbales de que las fuentes de noticias son sospechosas, como referencias a sesgos o una tendencia a difundir teorías de conspiración, dice.

“Si, por ejemplo, abres la página de Wikipedia de Breitbart , lees cosas como ‘misóginas’, ‘xenófobas’ ‘, racistas’ ‘, dice Nakov.

Las webs con dominios muy largos son generalmente menos confiables que las que lo tienen corto

Por otra parte, los sitios con nombres de dominio y estructuras de URL más complejos generalmente eran menos confiables que los sitios con nombres más simples. Algunas de las URL más complejas pertenecían a sitios con direcciones más largas que esencialmente se hacían pasar por conocidos con dominios más simples.

Los investigadores se enfocaron en rastrear la confiabilidad de los medios de comunicación completos en lugar de las historias individuales, en parte con la expectativa de que los algoritmos podrían ser mejores para manejar cuerpos completos de trabajo en lugar de publicaciones cortas.

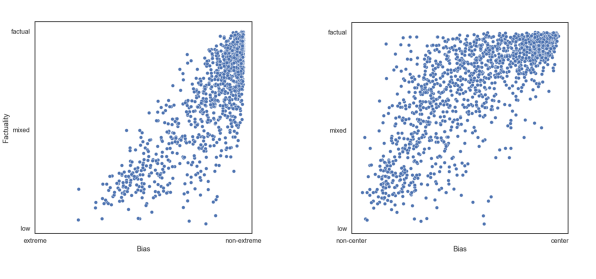

Cuando se presentó un nuevo canal de noticias, el sistema tenía aproximadamente un 65% de precisión en la detección de si tenía un nivel de factualidad alto, medio o bajo y el 70% de precisión en la detección de si se inclinaba hacia la izquierda, la derecha o el centro. Los investigadores planean presentar el documento en unas pocas semanas en la conferencia sobre Métodos empíricos en el procesamiento del lenguaje natural en Bruselas.

En el futuro, los investigadores del MIT y QCRI planean probar el sistema capacitado en inglés en otros idiomas y ver cómo se desenvuelve en otros sesgos distintos a los de la izquierda y la derecha, como detectar noticias religiosas o seculares en el mundo islámico. El grupo también tiene planes para una aplicación que podría ofrecer a los usuarios un vistazo a las noticias desde una variedad de perspectivas políticas, según el artículo.