Las mal llamadas fake news siguen causando verdaderos quebraderos de cabeza a los medios de comunicación, que en algunos casos han creado incluso equipos específicos o al menos un jefe de verificación, encargado de revisar que la información más importante, o sobre la que pudieran existir dudas, es verídica.

No se trata de la información que puede nacer contaminada de una fuente directa voluntaria o involuntariamente, porque la verificación de informaciones siempre ha existido, sino de no caer en la propagación de bulos o desinformaciones que han sido preparadas tan concienzudamente y pueden llegar a ser tan verosímiles que, sin un detenido análisis, pueden ser propagadas por error por el propio medio. Se las conoce por deepfakes, se alimentan en muchos casos con inteligencia artificial y son difíciles de detectar. Por ejemplo, ¿cuál de las dos imágenes inferiores es la falsa? Al final del artículo, la respuesta.

De momento, algunas de las tecnologías o destrezas para llevar a cabo estas deepfakes no están al alcance de cualquiera y en ámbitos regionales o locales, aún no se propagan con demasiada frecuencia, pero en el momento en que la tecnología y las destrezas se generalicen, van a ser un problema importante también para los medios locales, que en muchos casos carecen de los equipos necesarios para llevar a cabo estas revisiones.

El jefe de I + D en The Wall Street Journal, Francesco Marconi, y Till Daldrups investigador en el Journal, han compartido estos días a través de NiemanLab, algunas claves para detectar deepfakes:

¿Cómo se crean la mayoría de las “deepfake”?

La producción de la mayoría de los “deepfake” se basa en una técnica de aprendizaje automático denominada “redes de confrontación generativa” o GAN, por sus siglas en inglés (Generative Adversarial Networks).

Los falsificadores pueden utilizar esta técnica para intercambiar las caras de dos personas, por ejemplo, las de un político y un actor. El algoritmo busca instancias donde ambos individuos muestran expresiones y posicionamiento facial similares. En el fondo, los algoritmos de inteligencia artificial están buscando la mejor coincidencia para yuxtaponer ambas caras.

Debido a que la investigación sobre las GAN y otros enfoques para el aprendizaje automático está disponible públicamente, la capacidad de crear deepfakes se está extendiendo. El software de código abierto ya permite que cualquier persona con conocimientos técnicos y una tarjeta gráfica lo suficientemente potente pueda crear una deepfake.

Técnicas utilizadas para crear deepfakes.

Los creadores de deepfakes pueden usar una gran variedad de técnicas. Estas son algunas:

Cambio de cara : un algoritmo puede insertar sin problemas la cara de una persona en un vídeo objetivo. Esta técnica podría usarse para colocar la cara de una persona en el cuerpo de un actor y ponerla en situaciones en las que nunca estuvieron realmente.

Sincronización de labios : los falsificadores pueden injertar una boca en la cara de otra persona y sincronizar los labios. Combinar el material de archivo con un nuevo audio puede hacer que parezca que están diciendo cosas que no son.

Recreación facial: los falsificadores pueden transferir expresiones faciales de una persona a otro vídeo. Con esta técnica, los investigadores pueden jugar con la apariencia de una persona y hacer que parezcan disgustados, enojados o sorprendidos. En este vídeo se comprueba como los labios de Bush se mueven como los del presentador.

Transferencia de movimiento: los investigadores también han descubierto cómo transferir los movimientos corporales de una persona en un vídeo de origen a una persona en un vídeo objetivo.

Por ejemplo, pueden capturar los movimientos de un bailarín y hacer que los actores objetivo se muevan de la misma manera. En colaboración con investigadores de la Universidad de California, Berkeley, el corresponsal del diario Jason Bellini probó esta técnica y terminó bailando como Bruno Mars

¿Cómo se pueden detectar Deepfakes

“Estamos trabajando en soluciones y probando nuevas herramientas que pueden ayudar a detectar o prevenir deepfakes”, indica Marconi. “Hay técnicas de verificar si se ha modificado el material de archivo, como analizarlo fotograma a fotograma en un programa de edición de video para buscar formas no naturales y elementos agregados, o realizar una búsqueda de imagen inversa”, dijo Natalia V. Osipova, periodista de vídeo senior en el WSJ. Pero la mejor opción es a menudo el informe tradicional: “Comuníquese directamente con la fuente y el tema, y use su criterio editorial”.

Examinando la fuente

Si alguien ha enviado imágenes sospechosas, un buen primer paso es intentar contactar con la fuente. ¿Cómo la obtuvo esa persona? ¿Dónde y cuándo fue filmada? Obtener la mayor cantidad de información posible, solicitar una prueba adicional de las reclamaciones y luego verificar es clave.

Si el vídeo está en línea y el autor no se conoce, vale la pena hacerse estas preguntas: ¿Quién supuestamente filmó el video? ¿Quién lo publicó y lo compartió, y con quién? La verificación de los metadatos del video o la imagen con herramientas como InVID u otros visores de metadatos puede proporcionar respuestas.

“La tecnología por sí sola no resolverá el problema”, dice Rajiv Pant , director de tecnología del WSJ. “La forma de combatir las deepfakes es dotar a los equipos humanos con herramientas de inteligencia artificial”.

Encontrar versiones anteriores de las imágenes

Los deepfakes a menudo se basan en imágenes que ya están disponibles en línea. Los motores de búsqueda de imágenes inversas como Tineye o Google Image Search son útiles para encontrar posibles versiones más antiguas del vídeo para averiguar si un aspecto de este fue manipulado.

Examinando las imágenes

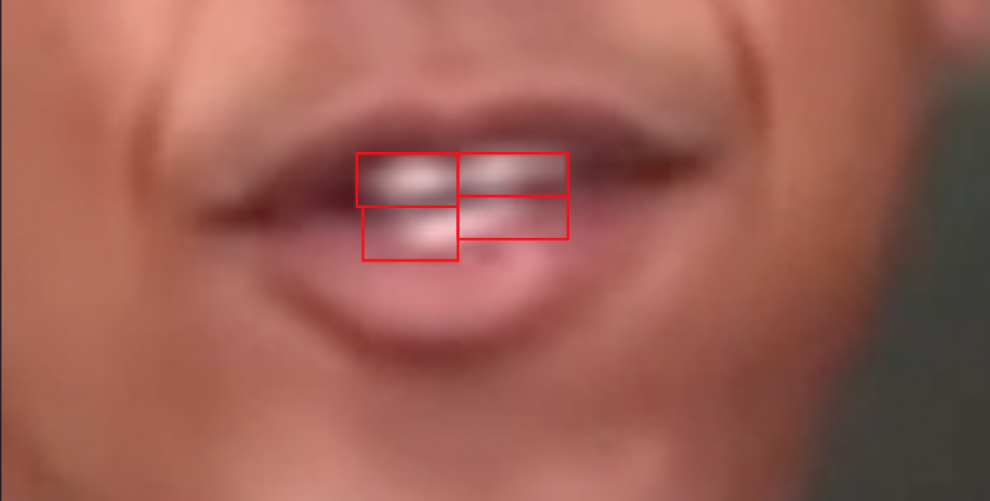

Programas de edición como Final Cut permiten a los periodistas reducir la velocidad de la grabación, hacer zoom en la imagen y mirarla fotograma a fotograma o pausar varias veces. Esto ayuda a revelar falsificaciones obvias: destellos y falta de claridad alrededor de la boca o la cara, luces o movimientos no naturales, y las diferencias entre los tonos de piel son signos reveladores de una falsificación profunda.

A modo de ejemplo, aquí hay algunos ejemplos que el equipo forense del Journal encontró durante una sesión de entrenamiento con imágenes de Barack Obama creadas por productores de vídeo en BuzzFeed.

Las formas de caja alrededor de los dientes revelan que esta es una imagen incrustada en el material de archivo original.

Las formas de caja alrededor de los dientes revelan que esta es una imagen incrustada en el material de archivo original.

Movimientos no naturales, como una barbilla cambiante y un cuello en crecimiento, muestran que las imágenes son falsas.

Movimientos no naturales, como una barbilla cambiante y un cuello en crecimiento, muestran que las imágenes son falsas.

Además de estos detalles faciales, también puede haber pequeñas ediciones en el primer plano o en el fondo del material de archivo. ¿Parece que se insertó o eliminó un objeto en una escena que podría cambiar el contexto del video (por ejemplo, un arma, un símbolo, una persona, etc.)? Nuevamente, la luz tenue, borrosa y antinatural puede ser un indicador de imágenes falsas.

En el caso del audio, “tenga cuidado con la entonación no natural, la respiración irregular, las voces metálicas y las ediciones obvias. Todos estos son indicios de que el audio puede haber sido generado por inteligencia artificial”.

Sin embargo, es importante tener en cuenta que los cambios de imagen y las imperfecciones también pueden ser resultado del proceso de compresión del vídeo. Por eso, a veces es difícil determinar de manera concluyente si un vídeo se ha manipulado o no.

Alteración del clima

Hay algoritmos para la manipulación de imágenes que permiten a los usuarios modificar el clima o la hora del día en un vídeo, como este ejemplo desarrollado por el fabricante de chips Nvidia mediante el uso de redes de confrontación generativas.

Estos algoritmos podrían utilizarse para la postproducción de escenas de películas tomadas durante días con diferentes climas. Pero esto podría ser problemático para las redacciones, porque para verificar las imágenes y reducir el tiempo de filmación de los vídeos, es común examinar la hora del día, el clima, la posición del sol y otros indicadores para detectar indicios de inconsistencias.

Voces artificiales

Los archivos de audio también pueden manipularse automáticamente: una compañía, Lyrebird , crea voces artificiales basadas en muestras de audio de personas reales. Un minuto de grabaciones de audio es suficiente para generar una réplica digital completa que puede decir cualquier oración que el usuario ingrese en el sistema. Las aplicaciones de esta tecnología incluyen permitir a los desarrolladores de videojuegos agregar voces a los personajes.

Las herramientas disponibles para el consumidor que facilitan la manipulación de vídeo y audio pueden acelerar la proliferación de deepfakes. Algunas de las compañías que están detrás de estas herramientas ya están considerando medidas de seguridad para evitar el uso indebido de su tecnología.

“Estamos explorando diferentes direcciones, incluidas las técnicas de marca de agua criptográfica, los nuevos protocolos de comunicación, así como el desarrollo de asociaciones con el mundo académico para trabajar en seguridad y autenticación”, dijo Alexandre de Brébisson , CEO y cofundador de Lyrebird .

Las ramificaciones de deepfakes para la sociedad.

Si bien estas técnicas se pueden usar para reducir significativamente los costos de producción de películas, juegos y entretenimiento, representan un riesgo para los medios de comunicación y para la sociedad en general. Por ejemplo, vídeos falsos podrían colocar a políticos en reuniones con agentes extranjeros o incluso mostrar a soldados cometiendo crímenes contra civiles. El audio falso puede hacer que parezca que los funcionarios del gobierno están planeando en privado ataques contra otras naciones.

“Sabemos que las deepfakes y otras manipulaciones de imagen son efectivas, este tipo de falsificaciones puede tener repercusiones inmediatas”, dijo Roy Azoulay , fundador y CEO de Serelay , una plataforma que permite a los editores proteger su contenido contra falsificaciones.

En Estados Unidos, algunos legisladores como los senadores Mark Warner y Marco Rubio ya están advirtiendo de escenarios como estos y están trabajando en posibles estrategias para evitarlos. Lo que es más, las deepfakes podrían usarse para engañar a los periódicos y socavar su confiabilidad.

La publicación de un vídeo falso no verificado en una noticia puede manchar la reputación de una redacción y, en última instancia, hacer que los ciudadanos pierdan más la confianza en los medios. Otro peligro para los periodistas: ataques personales que muestran a profesionales de las noticias en situaciones comprometedoras o alteraciones de los hechos, nuevamente para desacreditarlos o intimidarlos.

A medida que las deepfakes se abren paso en las redes sociales, su difusión probablemente seguirá el mismo patrón que otras noticias falsas. En un estudio del MIT que investigó la difusión de contenido falso en Twitter publicado entre 2006 y 2017, los investigadores encontraron que “el contenido falso se difundió significativamente más lejos, más rápido, y de manera más profunda y más amplia que la verdad en todas las categorías de información”.

Para acabar, aquí está la solución a la pregunta anterior: fue el vídeo de la izquierda el que se modificó con la ayuda de AI.

Un equipo de investigadores usó una forma de recreación facial llamada “Retratos profundos de video” para transferir los movimientos faciales de Barack Obama a la cara de Ronald Reagan. Esto es lo que parece: